Laravel y AWS: Backups Automáticos en S3

Guía para configurar copias automáticas de Laravel en S3: crear bucket, ajustar .env, usar Spatie Backup, Scheduler, AWS CLI y políticas de retención.

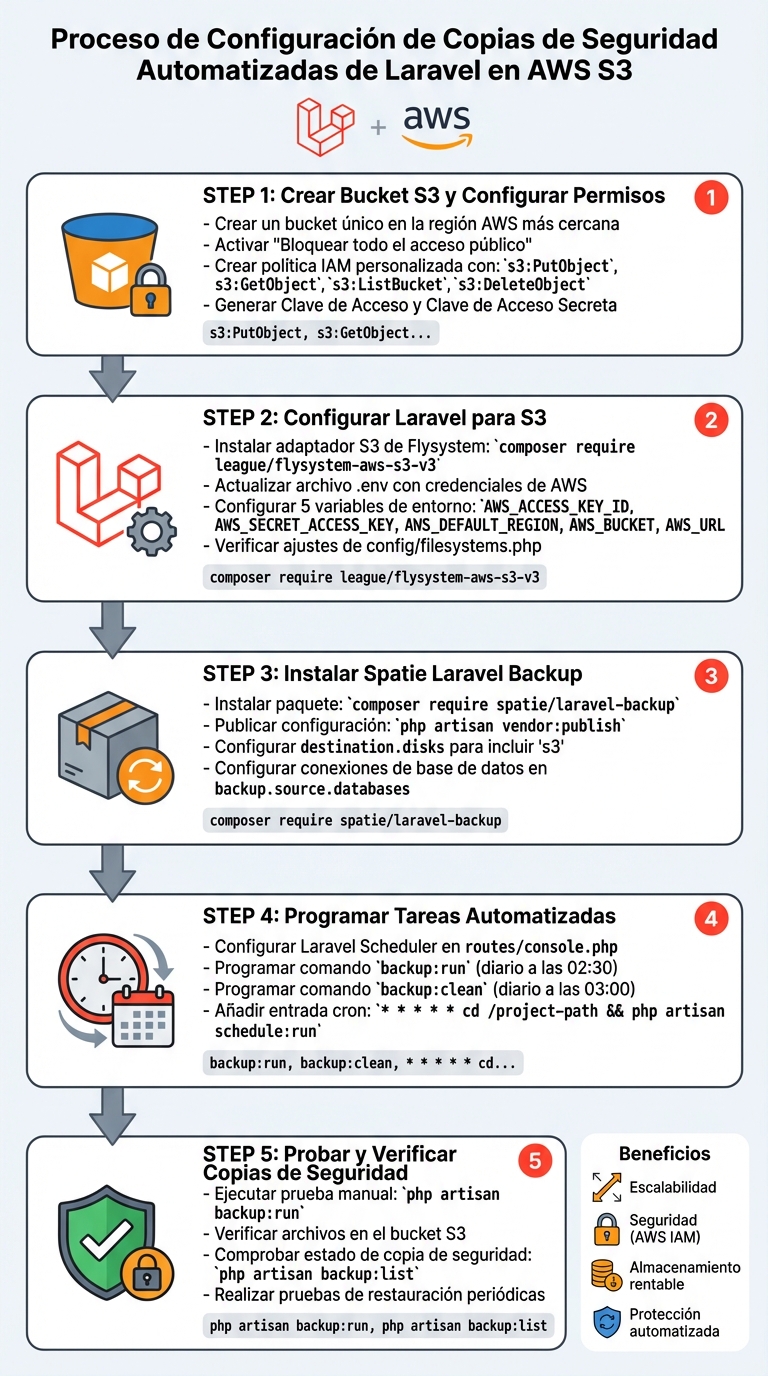

Proteger tus datos nunca ha sido tan sencillo. Configurar copias de seguridad automáticas con Laravel y Amazon S3 garantiza que tu información esté segura frente a fallos de hardware o errores humanos. Aquí tienes un resumen rápido de cómo hacerlo:

- Amazon S3 ofrece almacenamiento escalable, seguro y remoto para tus backups.

- Laravel facilita la integración con S3 gracias a su sistema de archivos y herramientas como el Task Scheduler.

- Spatie Laravel Backup automatiza las copias de seguridad de bases de datos y archivos, asegurando que siempre tengas una copia actualizada.

¿Qué necesitas?

- Crear un bucket en S3 con permisos personalizados.

- Configurar Laravel para usar S3 mediante el archivo

.envyconfig/filesystems.php. - Instalar y configurar el paquete Spatie Laravel Backup.

- Programar tareas automáticas con Laravel Scheduler.

- Probar regularmente las copias de seguridad y restaurarlas en caso necesario.

¿Por qué usar S3?

- Escalabilidad: Almacena desde megabytes hasta terabytes sin preocuparte por el espacio.

- Seguridad: Implementa controles de acceso con AWS IAM.

- Costes ajustables: Usa clases de almacenamiento como

Standard-IApara ahorrar.

Automatización con Laravel

- Configura backups diarios de bases de datos y archivos.

- Usa comandos como

backup:runybackup:cleanpara gestionar copias. - Evita errores humanos gracias a tareas programadas con Laravel Scheduler.

Buenas prácticas

- Verifica la integridad de tus backups con herramientas de Laravel y AWS.

- Implementa políticas de retención para optimizar espacio y costes.

- Realiza pruebas periódicas de restauración en entornos de prueba.

Con estos pasos, puedes proteger tu aplicación Laravel frente a cualquier imprevisto, asegurando que tus datos estén siempre accesibles y seguros.

5 pasos para configurar backups automáticos de Laravel en AWS S3

Configurar AWS S3 para copias de seguridad de Laravel

Crear un bucket de S3 y configurar permisos

Primero, accede a la consola de AWS S3 y crea un bucket único en una región cercana a tu ubicación para mejorar el rendimiento. Asegúrate de activar la opción "Bloquear todo el acceso público", desactivar las ACL y seleccionar "bucket-owner-enforced" para simplificar la gestión de permisos.

En lugar de asignar el permiso general de AmazonS3FullAccess, es mejor crear una política IAM personalizada. Esta debe incluir solo los permisos necesarios: s3:PutObject, s3:GetObject, s3:ListBucket y s3:DeleteObject para el ARN de tu bucket. Luego, crea un usuario IAM o un rol (si usas instancias EC2) y genera las claves de acceso (Access Key y Secret Access Key). Añade estas credenciales al archivo .env de tu proyecto Laravel.

Configurar Laravel para usar S3

Para integrar S3 en Laravel, instala el adaptador Flysystem S3 con el siguiente comando:

composer require league/flysystem-aws-s3-v3 "^3.0"

A continuación, actualiza el archivo .env con las credenciales de AWS. También verifica que el archivo config/filesystems.php tenga el disco s3 configurado correctamente. Si usas servicios compatibles con S3, como MinIO, añade esta línea al archivo .env:

AWS_USE_PATH_STYLE_ENDPOINT=true

A continuación, aquí tienes un desglose de las variables de entorno necesarias:

| Variable de entorno | Descripción | Ejemplo |

|---|---|---|

AWS_ACCESS_KEY_ID |

ID de acceso del usuario IAM | AKIA... |

AWS_SECRET_ACCESS_KEY |

Clave secreta del usuario IAM | wJalrXUtn... |

AWS_DEFAULT_REGION |

Región donde se encuentra el bucket | us-east-1 |

AWS_BUCKET |

Nombre exacto del bucket S3 | mis-backups-laravel |

AWS_URL |

URL base del bucket | https://bucket.s3.amazonaws.com |

Probar la conexión a S3

Para verificar que todo funciona correctamente, abre Tinker ejecutando:

php artisan tinker

Luego, prueba subir un archivo escribiendo:

Storage::disk('s3')->put('test.txt', 'contenido de prueba');

Finalmente, revisa la consola de AWS S3 para confirmar que el archivo test.txt se haya subido correctamente. Si encuentras errores, revisa los permisos asignados y asegúrate de que la región configurada en AWS_DEFAULT_REGION coincida con la del bucket.

Con esto, ya tienes S3 configurado. El siguiente paso será automatizar las copias de seguridad de la base de datos usando Spatie Laravel Backup.

Automatizar copias de seguridad de la base de datos en S3

Instalar y configurar Spatie Laravel Backup

Para automatizar las copias de seguridad de tus bases de datos en S3, utiliza el paquete Spatie Laravel Backup. Primero, instala el paquete ejecutando:

composer require spatie/laravel-backup

Luego, publica el archivo de configuración con el siguiente comando:

php artisan vendor:publish --provider="Spatie\Backup\BackupServiceProvider" --tag="backup-config"

Esto generará un archivo llamado config/backup.php. Dentro de este archivo, asegúrate de configurar la sección destination.disks para incluir 's3'. Además, verifica que tu conexión de base de datos (por ejemplo, 'mysql') esté incluida en backup.source.databases.

Si el sistema no encuentra mysqldump, especifica su ruta completa en el archivo config/database.php (por ejemplo, /usr/bin/mysqldump). Si trabajas con bases de datos grandes, es recomendable aumentar el valor de dump.timeout más allá de los 60 segundos predeterminados para evitar interrupciones durante el proceso de copia.

Una vez configurado el paquete, el siguiente paso es programar las copias de seguridad.

Programar copias de seguridad con Laravel Scheduler

Laravel Scheduler facilita la automatización de tareas sin necesidad de crear múltiples entradas cron. Para programar las copias de seguridad, edita el archivo routes/console.php y añade las siguientes líneas:

use Illuminate\Support\Facades\Schedule;

Schedule::command('backup:run --only-db --only-to-disk=s3')

->dailyAt('02:30')

->withoutOverlapping();

Schedule::command('backup:clean')

->dailyAt('03:00');

El método withoutOverlapping() evita que las tareas se ejecuten simultáneamente si alguna se retrasa. Por otro lado, el comando backup:clean elimina copias antiguas según las reglas de retención que hayas configurado.

Un detalle importante: no programes tareas entre las 02:00 y las 03:00 en regiones con horario de verano para evitar posibles problemas de duplicación o fallos en las ejecuciones.

Ejecutar copias de seguridad en el servidor

Con las tareas programadas, necesitas asegurarte de que Laravel Scheduler se ejecute en el servidor. Para ello, añade una entrada cron. Accede al servidor mediante SSH y abre el archivo cron con:

crontab -e

Dentro del archivo, añade esta línea (ajustando la ruta a tu proyecto):

* * * * * cd /ruta-de-tu-proyecto && php artisan schedule:run >> /dev/null 2>&1

Esta tarea se ejecutará cada minuto, y Laravel Scheduler determinará internamente qué comandos deben ejecutarse según la programación establecida.

Para comprobar que todo funciona correctamente, ejecuta manualmente el siguiente comando:

php artisan backup:run --only-db --only-to-disk=s3

Luego, verifica en tu bucket de S3 que se haya generado un archivo .zip. También puedes usar este comando:

php artisan backup:list

Con él, podrás revisar el estado de las copias de seguridad almacenadas y asegurarte de que todo está en orden.

Hacer copias de seguridad de archivos y carpetas de almacenamiento en S3

Configurar copias de seguridad de archivos con Spatie Laravel Backup

Además de proteger tu base de datos, es fundamental respaldar los archivos y carpetas clave de tu aplicación. Con el paquete Spatie Laravel Backup, puedes incluir archivos específicos en un archivo .zip que se sube a S3. Para configurarlo, abre el archivo config/backup.php y edita la sección source.files.include. Agrega las rutas necesarias usando los helpers de Laravel:

'include' => [

storage_path('app'),

public_path('storage'),

],

Por otro lado, para evitar que el archivo zip crezca demasiado, excluye carpetas innecesarias en source.files.exclude. Por ejemplo, puedes añadir:

'exclude' => [

base_path('vendor'),

base_path('node_modules'),

],

Además, ajusta 'relative_path' => base_path() para que la estructura del archivo .zip sea precisa y no incluya rutas absolutas del sistema.

Si tu carpeta de almacenamiento contiene una gran cantidad de datos (como cientos de gigabytes), el proceso de compresión podría consumir demasiado espacio en disco. En estos casos, es mejor usar herramientas como AWS CLI para sincronizar directamente los archivos, evitando la compresión.

Usar AWS CLI para sincronización directa de archivos

Cuando trabajas con grandes volúmenes de datos o necesitas más control, AWS CLI es una opción eficiente. El comando aws s3 sync permite sincronizar un directorio local con S3 sin comprimir, transfiriendo solo los archivos nuevos o modificados.

Primero, instala AWS CLI en tu servidor. Descarga, descomprime y ejecuta el script de instalación. Luego, configura tus credenciales con el comando aws configure, introduciendo tu Access Key ID, Secret Access Key y la región (por ejemplo, eu-west-1) [20,22]. Puedes verificar que todo funcione correctamente con:

aws --version

Para sincronizar tu carpeta de almacenamiento, utiliza un comando como este, especificando la ruta absoluta de tu proyecto:

aws s3 sync /var/www/html/tu-proyecto/storage s3://tu-bucket/storage

Con AWS CLI configurado, puedes automatizar estos pasos para mayor comodidad.

Automatizar la sincronización de archivos mediante Laravel Scheduler

Una vez que tengas la sincronización manual configurada, puedes automatizarla con Laravel Scheduler. Esto te permitirá programar tanto las copias de seguridad con Spatie como las sincronizaciones con AWS CLI.

Para realizar una copia de seguridad de archivos con Spatie, añade el siguiente código a routes/console.php:

Schedule::command('backup:run --only-files --only-to-disk=s3')

->dailyAt('04:00')

->withoutOverlapping();

Si prefieres usar AWS CLI para sincronizar directamente los archivos, utiliza el método exec():

Schedule::exec('aws s3 sync /ruta/absoluta/storage s3://tu-bucket/storage')

->hourly()

->withoutOverlapping(); // Evita que se ejecuten procesos simultáneos

Automatizar estos procesos no solo ahorra tiempo, sino que también garantiza que tus datos estén siempre respaldados y actualizados.

Buenas prácticas para la gestión de copias de seguridad

Verificar la integridad de las copias de seguridad

Hacer copias de seguridad es solo el primer paso; también es crucial asegurarse de que sean completas y funcionales. El paquete Spatie Laravel Backup incluye un sistema de monitorización que valida aspectos como MaximumAgeInDays (para garantizar que las copias sean recientes) y MaximumStorageInMegabytes (para detectar tamaños anómalos). Puedes usar el comando php artisan backup:list para obtener un resumen del estado de tus copias.

Además, verifica manualmente los archivos con métodos como Storage::exists(), size() y lastModified() para confirmar que están correctamente almacenados en S3. Si prefieres la línea de comandos, utiliza aws s3 ls s3://tu-bucket --recursive para listar los objetos. No olvides realizar pruebas periódicas de restauración descargando una copia y probándola en un entorno de pruebas.

Restaurar desde las copias de seguridad

Una vez confirmada la integridad, puedes proceder a restaurar los datos. Para bases de datos, descarga el archivo .sql.gz desde S3 mediante la consola de AWS o usando aws s3 cp s3://tu-bucket/ruta/archivo.sql.gz ./. Descomprime el archivo con gunzip archivo.sql.gz y restáuralo con mysql -u usuario -p nombre_base_datos < archivo.sql.

Si trabajas con Spatie Laravel Backup, los archivos suelen estar en formato .zip. Descárgalos y extrae su contenido con unzip archivo.zip. Para recuperar archivos individuales, Laravel ofrece una solución directa con Storage::disk('s3')->download('ruta/archivo').

Implementar políticas de retención y monitorización

Gestionar el ciclo de vida de las copias de seguridad también es clave. Las políticas de ciclo de vida de S3 permiten optimizar costes moviendo las copias a clases de almacenamiento más económicas. Por ejemplo, conserva copias diarias durante 2 semanas en S3 Standard, las semanales durante 3 meses en S3 Standard-IA, y las anuales en S3 Glacier Deep Archive.

Desde Laravel, programa tareas automáticas como php artisan backup:clean en routes/console.php para eliminar copias antiguas según las reglas de config/backup.php. Configura notificaciones por correo en notifications.mail.to para recibir alertas en caso de fallos o problemas detectados en las copias. Por último, revisa regularmente los logs de Laravel y AWS CloudTrail para identificar accesos no autorizados o errores en las llamadas a la API relacionadas con tus backups.

How to take Backup of Laravel Application and Store it on Amazon S3

Conclusión

Configurar copias de seguridad automáticas en S3 es una inversión clave para garantizar la continuidad de tu proyecto. Como menciona Moreweb.be:

Las copias de seguridad son importantes. Mantener copias de seguridad regulares de las bases de datos de tu sitio web (o del de tu cliente) puede salvarte la vida en caso de eventos inesperados. Con suerte, nunca tendrás que recurrir a ellas, pero tenerlas disponibles, sabiendo que puedes hacer un rollback al estado de ayer en minutos, te da tranquilidad.

Integrar herramientas como Spatie Laravel Backup, el Task Scheduler de Laravel y S3 permite reducir al mínimo los errores humanos y asegura que tus datos estén protegidos de manera constante. Además, S3 ofrece almacenamiento a un coste razonable, especialmente con opciones como Standard-IA, ideal para copias de seguridad de acceso poco frecuente. Esto añade una capa extra de protección que simplifica enormemente la recuperación ante desastres.

No olvides realizar pruebas regulares de integridad y restauración para garantizar que tus copias sean funcionales cuando las necesites. Más allá de crear backups, estas prácticas aseguran su fiabilidad.

También es crucial establecer políticas claras de retención y configurar notificaciones para identificar posibles fallos de inmediato. Usa comandos como php artisan backup:clean para mantener un control constante del estado de tus copias. Con estas medidas, tu aplicación Laravel estará lista para enfrentarse a cualquier imprevisto. Ajusta periódicamente las políticas de respaldo según las necesidades específicas de tu proyecto.

FAQs

¿Cómo puedo configurar los permisos de un bucket S3 para usarlo con Laravel?

Para que tu aplicación Laravel pueda interactuar de manera segura con un bucket S3, es fundamental configurar correctamente los permisos. Aquí tienes los pasos clave:

-

Crear una política para el bucket

Diseña una política que permita las acciones necesarias, como lectura y escritura, pero restringiendo el acceso únicamente a lo imprescindible. Esto asegura que solo se realicen las operaciones necesarias. Una vez creada, aplica esta política directamente al bucket desde la consola de AWS. -

Configurar un usuario IAM

Crea un usuario IAM y genera sus credenciales (clave de acceso y clave secreta). A este usuario, asígnale una política que limite su acceso exclusivamente al bucket S3 que usará Laravel. Esto añade una capa extra de seguridad, evitando accesos no autorizados. -

Actualizar el archivo

filesystems.phpen Laravel

En el archivo de configuraciónfilesystems.php, introduce las credenciales del usuario IAM, junto con la región y el nombre del bucket. Esto permitirá que Laravel se conecte correctamente a S3 y gestione los archivos según los permisos configurados.

Con estos ajustes, tu aplicación Laravel estará lista para trabajar con S3 de forma segura y eficiente.

¿Cómo puedo probar y restaurar mis copias de seguridad almacenadas en S3?

Para garantizar que tus copias de seguridad de S3 estén completas y funcionales, sigue estos pasos detallados:

1. Verifica tus copias de seguridad

Antes de cualquier restauración, asegúrate de que los archivos están correctamente almacenados en tu bucket de S3. Puedes hacerlo accediendo a la consola de AWS y revisando que los archivos necesarios estén presentes y sin errores.

2. Descarga el archivo de respaldo

Utiliza la consola de AWS o herramientas como AWS CLI para transferir el archivo de respaldo a tu entorno local o de desarrollo. Aquí tienes un ejemplo usando AWS CLI:

aws s3 cp s3://tu-bucket/archivo-backup.sql ./backup.sql

Este comando descargará el archivo archivo-backup.sql desde tu bucket de S3 a tu máquina local.

3. Restaura la base de datos

Con el archivo descargado, puedes restaurar la base de datos. Por ejemplo, si usas MySQL, ejecuta el siguiente comando en tu terminal:

mysql -u usuario -p base_de_datos < backup.sql

Este comando importa los datos del archivo backup.sql a la base de datos especificada. Asegúrate de reemplazar usuario y base_de_datos con los valores correspondientes.

Consejos adicionales

- Realiza estas pruebas en un entorno de desarrollo para evitar problemas en producción.

- Verifica que tienes los permisos necesarios tanto en tu bucket de S3 como en tu base de datos para ejecutar estas acciones sin inconvenientes.

¿Cómo configurar la sincronización automática de archivos grandes con AWS CLI?

Para gestionar archivos grandes de manera eficiente entre tu equipo local y un bucket de S3, puedes usar el comando sync de AWS CLI. Este comando facilita la copia de archivos al comparar las diferencias entre el origen y el destino, asegurando que solo se transfieran los cambios necesarios.

Pasos para sincronizar archivos grandes

- Configura AWS CLI: Asegúrate de tener configuradas tus credenciales y permisos adecuados para acceder al bucket S3.

-

Ejecuta el comando

sync: Usa el siguiente formato, adaptándolo a tus rutas y nombres de bucket:aws s3 sync /ruta/local s3://nombre-del-bucket/ - Automatiza la sincronización: Puedes programar el comando mediante un cron job en sistemas Linux o con un script de PowerShell en Windows. Esto asegura que el proceso se ejecute regularmente sin intervención manual.

Opciones útiles para optimizar el proceso

--exact-timestamps: Mantiene las marcas de tiempo exactas de los archivos, evitando transferencias innecesarias.--delete: Elimina en el destino los archivos que ya no existan en la carpeta de origen.

Estas opciones son especialmente útiles cuando trabajas con grandes volúmenes de datos, permitiendo una gestión eficiente y segura sin malgastar recursos.